Corinna Cichy, Doktorandin, BICC & Risikodaten-Strategie, Aufsatz von Prozessen und Methoden im Data Quality Management, Volkswagen Bank GmbH

Dr. Piet Usselmann, Data Engineering, BICC & Risikodaten-Strategie, Projektleiter für Ausbau des zentralen Datenhaushaltes der VW Financial Services Deutschland anhand der fachlichen Anforderungen der Fachbereiche (u. a. fachliche Architektur und Datenmodellierung), Volkswagen Bank GmbH

I. Einleitung

Der Geschäftswert von Daten für Unternehmen wird maßgeblich von ihrer Datenqualität beeinflusst. Probleme in der Qualität von Daten können weitreichend und äußerst kostspielig sein. Für den Umgang mit Datenqualitätsproblemen wird die Nutzung von Rahmenwerken empfohlen. Diese können die Priorisierung von Datenqualitätsverbesserungen auf die wesentlichen und kritischen Probleme sowie fundierte Entscheidungen über potenzielle Kompromisse definieren[1]. Bei der Umsetzung eines effizienten Datenqualitätsmanagements (DQM) in der Praxis sind die Datenarchitektur, der Anforderungsprozess sowie ein Rollenmodell zur Handhabung von Daten über den Gesamtprozess ebenfalls von zentraler Bedeutung.

In diesem Beitrag wird zunächst Datenqualität definiert und anschließend die Anforderung der Regulatorik praxisorientiert ausgelegt. Weiterhin werden Erfolgsfaktoren im Datenqualitätsmanagement vorgestellt[2].

II. Datenqualität und Metriken

1. Definition von Datenqualität

In der Literatur wird das Konzept der Datenqualität in verschiedene Dimensionen unterteilt. Diese beziehen sich auf Aspekte wie Vollständigkeit, Genauigkeit, Konsistenz oder auch Aktualität von Daten[3]. In der Praxis liegt der Fokus hingegen auf der Kontext- und Benutzerabhängigkeit. Zum Beispiel wird gemäß der ISO 8000[4] Datenqualität als der Grad, zu dem Daten die an sie gestellten Anforderungen erfüllen, definiert. Qualitätsdaten sind also Daten, welche die an sie gestellten Anforderungen vollständig erfüllen.[5]

Abseits von abstrakten Rahmenwerken sollte sich jeder Datennutzer im Sinne einer Kosten-/ Nutzen-Betrachtung jedoch die Frage stellen: „Brauche ich wirklich 100 % korrekte Daten oder reichen 90 % und ein Ausweis der Fehlerquote?“ Es darf keine DQ-Prüfungen zum Selbstzweck geben, sondern die Prüfungen müssen konkreten nachvollziehbaren Anforderungen folgen. Als Aufwand für Datenqualität im Verhältnis zum Nutzen kann man überschlagsmäßig die 1–10–100 Regel anwenden:[6]

- 1$ Kosten bei Eingabe von z. B. Kundenstammdaten im Frontend

- 10$ Kosten zur regelmäßigen Bereinigung

- 100$ Kosten beim Nichtstun

Ziel von Datenqualität ist ein klares Bewusstsein für die Limitierung von Daten durch ihre Qualität. Perfekte Datenqualität kann, aber muss nicht erreicht werden; unternehmerische Entscheidungen hingegen müssen informiert getroffen werden!

Um Datenqualität messbar zu machen, werden Indikatoren für die jeweils relevanten Dimensionen vorgeschlagen. Als objektive Metrik kann z. B. die prozentuale Vollständigkeit oder Gültigkeit von Daten bzgl. Validierungsregeln auf Datenfeld- oder Modulebene berechnet werden. Eine Datenqualitätsbewertung kann zusätzlich durch Experten und Datenkonsumenten erfolgen um die Gebrauchstauglichkeit der Daten in Hinblick auf potenzielle Konsequenzen zu beurteilen.

2. Datenqualität in der Regulatorik

Auch in der Regulatorik finden sich die Dimensionen der Datenqualität wieder. Die in dem eher theoretisch ausgeprägten Rahmenwerk von BCBS 239[7] verfassten Grundsätze enthalten Kriterien zur Datenqualität in Bezug auf die Gesamtunternehmensführung und Infrastruktur, Risikodaten-Aggregationskapazitäten sowie Risikoberichterstattung mit dem Ziel, diese Prozesse zu stärken. Die Bundesbank stellt zudem Anforderungen an die Pünktlichkeit, Richtigkeit und Konsistenz, Stetigkeit, Vollständigkeit sowie Plausibilität von Daten des Meldewesens[8]. Bei der Umsetzung regulatorischer Vorgaben sollte der Nutzen für das Unternehmen unabhängig von der Compliance im Vordergrund stehen. Eine vorbereitende Analyse der geforderten Dimensionen ist daher von Vorteil.

Aus dem Meldewesen heraus gibt es konkrete Beispiele für die Anwendung von Datenqualitätsregeln. Am Beispiel der Richtigkeit und Konsistenz wird im Folgenden die Erwartung im (engeren) Sinne der Aufsicht sowie im erweiterten Sinne für eine Qualitätsmessung in Instituten erläutert[9]. Die Aufsicht bezieht sich hierbei konkret auf die Richtigkeit einer übermittelten Meldung. Die Messung erfolgt z. B. über die Anzahl fehlerhafter (bekannter) Validierungsregeln sowie zusätzliche Qualitätschecks. Die Konsistenz greift auf den logischen Zusammenhang zwischen einzelnen Vordrucken, Modulen und den Institutsstammdaten zu (interne und externe Konsistenz). Im erweiterten Sinne sind Messung durch die vom Anforderer übermittelten DQ-Regeln (Korrektheit, Verlässlichkeit, und Sicherheit) sowie eine redundanzfreie Lieferung zu verstehen. Als harte Messkriterien können die absolute/prozentuale Anzahl an Validierungsfehlern oder die Konzentration in bestimmten Validierungsfehlern verwendet werden.

Sämtliche Anforderungen aus BCBS 239 sind in ihrem engeren Fokus für die Aufsicht und im weiteren Sinne für die Steuerung im Unternehmen zu interpretieren.

Eine Erfüllung sämtlicher Datenanforderungen ist in der Praxis jedoch nicht möglich. Daher ist bei der Abarbeitung von Datenqualitätsmängeln eine Priorisierung notwendig.

III. Erfolgsfaktoren im Datenqualitätsmanagement

In der Praxis hat sich gezeigt, dass folgende Faktoren für den erfolgreichen Einsatz eines Datenqualitätsmanagements berücksichtigt werden sollten: eine gute Datenarchitektur, ein strukturierter Anforderungsprozess sowie ein Rollenmodell zur Handhabung von Daten über den Gesamtprozess.

1. Architektur Datenhaushalt

Um die Bedeutung eindeutiger Definitionen und eines gemeinsamen Verständnisses darzustellen, soll folgendes Beispiel dienen: Wer wird Deutscher Meister? Leipzig, Dortmund, München, ein anderer Verein?

Bezogen auf die Fußball Bundesliga der Männer ist diese Frage in den letzten Jahren einfach zu beantworten. Gesucht war hier jedoch MGC Dormagen-Brechten – der mehrfache deutsche Meister im Minigolf. Den Kontext („Welche Sportart“) gibt die Frage nicht mit!

Bei derartigen Fragestellungen sind daher eine eindeutige Definition und ein gemeinsames Verständnis notwendige Kriterien für die Datenqualitätsmessung. Diese kann nur so gut sein wie die Architektur und die Beschreibung des zugrundeliegenden Datenhaushalt.

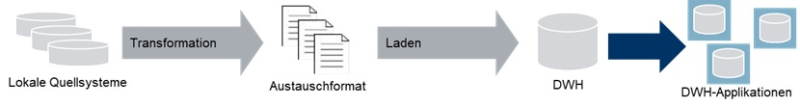

Abbildung 1: Möglicher Aufbau eines gemeinsamen Datenhaushaltes (DWH)

Bei der Architektur eines gemeinsamen Datenhaushalts, der von verschiedenen Datenabnehmern genutzt wird, ist zu klären, wo die Transformation der lokalen Quelldaten stattfindet, ob lokale Details benötigt werden, was mit Daten aus Zentralapplikationen passiert, und wie Rechenkerne integriert werden können.

Für eindeutige Definitionen und ein einheitliches Verständnis sollte die „Daten-Taxonomie“ als gemeinsame Sprache verwendet werden. Die Daten-Taxonomie setzt sich u. a. aus dem Datenmodell, einem (fachlichen!) Glossar, Referenzdaten und Beispielen zusammen.

Dabei gilt der Grundsatz, dass (fast) alles ausschließlich fachlich beschrieben werden sollte! Das heißt insbesondere: Keine Tabellen (sondern Geschäftsobjekte), keine Systeme (sondern Fachprozesse), keine technischen Datentypen und kein SQL. Stattdessen sollte die Beschreibung strukturiert (kein Fließtext, aber auch nicht zu formal), konsistent und verständlich sein.

Hierbei gilt, dass die Daten-Taxonomie vor allem der Kommunikation dient, d. h. die Verständlichkeit ist wichtiger als eine formale Präzision, Ausdrucksmächtigkeit, oder die Vorwegnahme möglicher zukünftiger Entwicklungen.

2. Systematische DQ-Messungen und -Bewertungen

Basierend auf der gewählten Architektur gilt das Datenmodell als „Sprache“ zur Definition der DQ-Anforderungen. Auf Grundlage der in Kapitel II dargestellten Datenqualitätsdefinition bezieht sich diese somit auf die Erfüllung der an sie gestellten Anforderungen. DQ-Anforderungen sollten dabei in Form von sogenannten Business-Regeln gestellt werden, die sich den Dimensionen der Regulatorik zuordnen lassen und durchaus hohe Granularität aufweisen (z. B. Datenfeldebene).

3. Grundlegendes Rollenmodell für den Umgang mit Daten

Für die schnelle und leicht erreichbare Datennutzung werden die notwendigen Prozesse durch eine zentrale Funktion zur Verfügung gestellt. In der Praxis kann dies z. B. durch ein BI Competence Center (BICC) erfolgen. Diese Einheit unterstützt als neutrale Instanz, welche zwischen Fachbereichen und IT angeordnet ist, die beteiligten Akteure bei der effizienten Identifikation von Daten und Verantwortlichkeiten, konsolidiert die Anforderungen im Fall mehrerer Nutzer und sorgt für Data Lineage und Dokumentation der Daten und Metadaten.

Abbildung 2: Grundlegendes Rollenmodell für den Umgang mit Daten

4. Zentrale Datenqualitätsmanagements-Funktion

Ergänzend zum BICC (oder innerhalb dieses aufgebaut) sollte ein zentrales Datenqualitätsmanagement (DQM) entwickelt werden. Ziele einer zentralen DQM-Funktion sind die Transparenz über die DQ-Anforderungen, die Koordination der DQ-Probleme (Defects) und die Abstimmung der Prioritäten zur Abarbeitung, die Konsolidierung bestehender und zukünftiger Anforderungen und die zentrale Kommunikationsstelle zur DQ Performance. Prozessual kann eine solche Funktion wie folgt arbeiten:

Abbildung 3: Rollen und Aufgaben im zentralen Datenqualitätsmanagement

Wichtig für die Umsetzung in der Praxis sind klare Prämissen für die Zusammenarbeit mit Daten-Anforderern und -Lieferanten. Es empfiehlt sich daher, den Scope auf den produktiven Datenhaushalt einzuschränken, die durch das BICC definierten und veröffentlichten systematischen DQ-Messungen als Basis für die DQ-Anforderungen zu verwenden, potenzielle DQ-Probleme frühestmöglich zu erkennen und Korrekturmaßnahmen zukunftsgerichtet durchzuführen, d. h. insbesondere haben diese durch den Datenlieferanten in den Quellen zu erfolgen und nicht in den Applikationen.

Mithilfe einer klaren Rollendefinition lassen sich die Aufgaben einer zentralen DQM-Funktion strukturieren. Zur Erreichung der Ziele bietet sich eine Aufteilung in vier übergeordnete Handlungsbereiche an:

- Das zentrale DQM steuert Datenqualität. Dies beinhaltet die Abstimmung mit den Stakeholdern, eine übergreifende Priorisierung von DQ-Problemen inkl. Eskalation, die Konzeption von DQM-Kennzahlen, Analysen und Statusberichten.

- Datenqualität wird an zentraler Stelle analysiert. Hierbei werden Daten überprüft, DQ-Probleme identifiziert, bewertet und strukturiert erfasst sowie über den Zeitverlauf verglichen.

- Die Kommunikation zum Thema Datenqualität wird gebündelt. Hier werden Defects an Datenlieferanten kommuniziert und priorisiert. Vereinbarte Maßnahmen werden überwacht. An dieser Stelle kann ebenfalls ein First-Level-Support bei Rückfragen bereitgestellt werden.

- Das zentrale DQM unterstützt die Fehlerbehebung. Datenlieferanten werden bei der Behebung von Defects operativ unterstützt. Maßnahmen zu nachhaltigen, zukunftsgerichteten DQ-Verbesserungen (z. B. Prozessoptimierungen, DQ-Prüfungen in Datenquellen) werden gemeinsam mit den Lieferanten erarbeitet.

V. Zusammenfassung und Fazit

Daten sind das neue Gold! Doch liegt in ihrem Datenhaushalt Katzengold oder Feingold? Hier hilft die „gefühlte“ (Daten-)Qualität nicht weiter. Nur die tatsächlich gemessene Qualität bringt entscheidende Vorteile für das Unternehmen. Definieren Sie für sich Datenqualität und leiten Sie granulare Business-Regeln aus den Dimensionen der Regulatorik für eine gezielte Datenqualitätsprüfung ab. Sorgen Sie mit einem zentralen DWH und einer gemeinsamen Sprache (Daten-Taxonomie) für die Konsistenz von Daten in den verschiedenen Bereichen (Controlling, Melde- und Rechnungswesen). In diesem Beitrag wurde gezeigt, wie mit geeigneten Prozessen ein Datenqualitätsmanagement aufgebaut werden kann. Die Datenqualität fällt jedoch nicht vom Himmel – holen Sie die Verantwortlichen für Applikationen ab und geben Sie sich gemeinsam genügend Zeit.

Wichtig bei allen Umsetzungsaktivitäten bleibt: Perfekte Datenqualität kann und muss nicht erreicht werden, aber unternehmerische Entscheidungen müssen informiert getroffen werden!

PRAXISTIPPS

- Sorgen Sie für eine positive Wahrnehmung von DQM-Aufgaben in der Bank (Verortung in übergreifender Strategie sinnvoll).

- Kennzeichnen Sie die DQM-Aufgaben als anspruchsvolle Tätigkeit mit hoher fachlicher, analytischer Anforderung in Kombination mit hoher Kommunikationskompetenz (Wertigkeit).

- Stellen Sie einen graduellen Übergang der Aufgabe von bisherigen dezentralen Funktionen an die neue Zentralfunktion sicher (Sicherstellung und Weiterentwicklung des Leistungsspektrums).

- Definieren Sie klare DQ-Fehlermanagement-Prozesse, um koordinierte und effiziente Arbeitsabläufe sowie Transparenz in der DQ-Verbesserung zu erzielen.

[1] van der Meulen: „Make Financial Data Decision-Ready.” Gartner, 2020.

[2] Weitere Aspekte zum Thema Datenqualität finden sich auch in Hein/Scheve (Hrsg.): Handbuch Datenmanagement.

[3] Cichy/Rass: „An Overview of Data Quality Frameworks,” IEEE Access, vol. 7, S. 24.634–24.648. 2019.

[4] In Entwicklung, 2020 letzte Veröffentlichung zu Data quality — Part 2: Vocabulary (https://www.iso.org/standard/80543.html).

[5] Selke: „Praktisches Datenqualitätsmanagement (DQM), BankPraktiker 2014 S.420–427.

[6] Labovitz, Chang, Rosansky: Making Quality Work: A Leadership Guide for the Results-Driven Manager.

[7] Basel Committee on Banking Supervision: Principles for Effective Risk Data Aggregation and Risk Reporting. BCBS 239. 2013.

[8] https://www.bundesbank.de/de/service/meldewesen/bankenaufsicht/datenqualitaet-des-harmonisierten-meldewesens/datenqualitaet-des-europaeisch-harmonisierten-meldewesens-611542

[9] Beispiel eines Dashboards der EZB: https://www.bankingsupervision.europa.eu/press/conferences/shared/pdf/sup_rep_conf/2018/DataQualityIndicatorForIndividualBanks.pdf (S. 15).